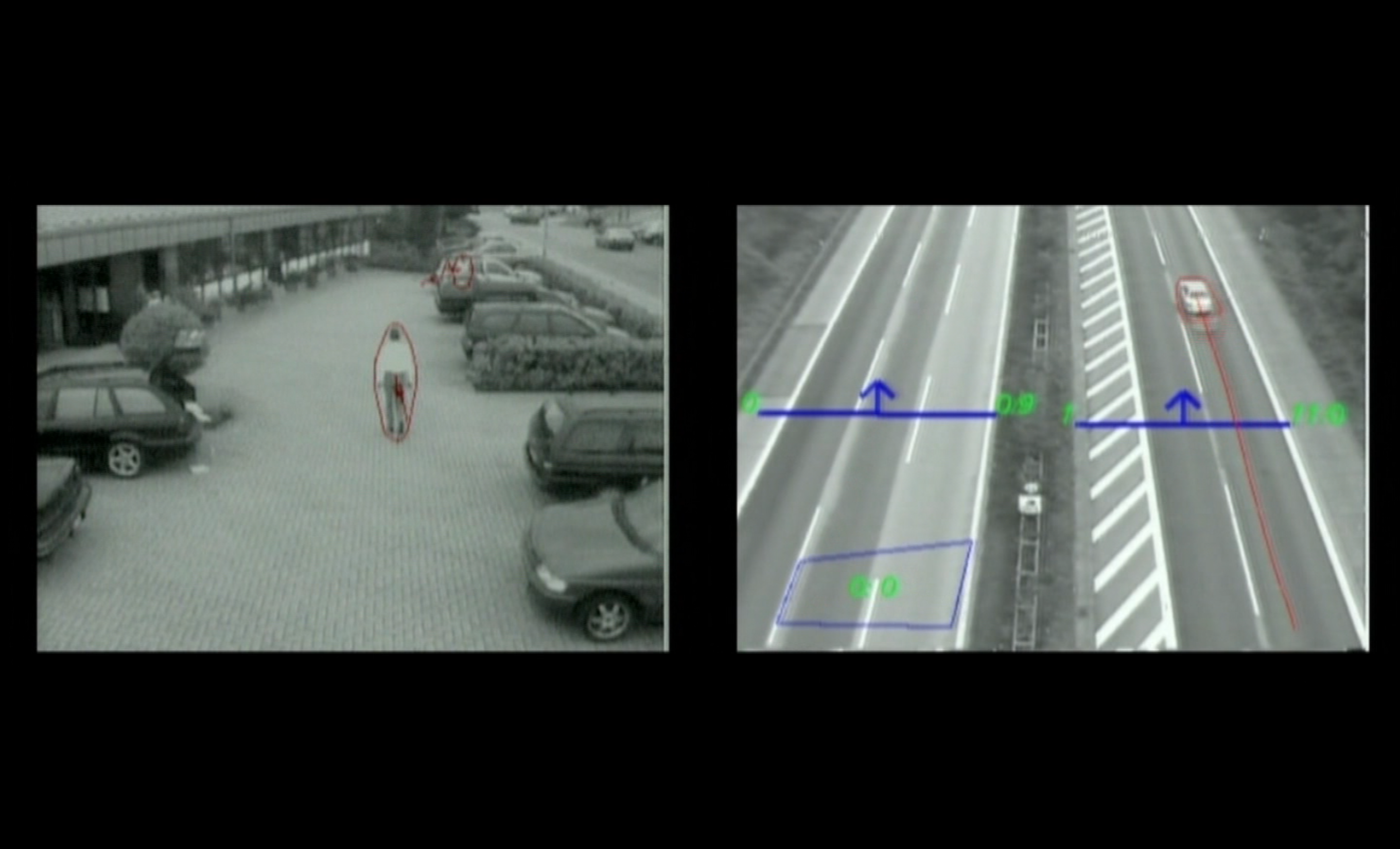

Grautönige, verpixelte Überwachungsbilder, auf denen Algorithmen in farbigen Linien Abmessungen einzeichnen und Abstände zwischen den Menschen und der Architektur markieren, durch die sie sich hindurch bewegen. Auf dem linken Kanal formen rote und blaue Linien ovale Kreise um sich auf einem Parkplatz bewegende Menschen, während sich auf dem Kanal auf der rechten Seite des Bildschirmes eckige Formen um Autos und LKWs herum ausbreiten. „Diesen Bildern fehlte die Anschaulichkeit“, heisst es in einer Filmszene des Filmemachers Harun Farocki (Farocki 2001).

Die hier beschriebene Sequenz stammt aus Farockis Auge/Maschine, einem dreiteiligen Videoessay aus dem Jahr 2001. In der Tat sind es zunächst völlig belanglos erscheinende Aufnahmen, die wir zu sehen bekommen: Überwachungsbilder festmontierter Kameras von schlechter Videoqualität, die nichts Aussergewöhnliches zeigen und lediglich die Einhaltung einer bestimmten Norm sicherstellen sollen, indem sie Menschliches und Nichtmenschliches als Objekte in Bewegung erkennen.

Abb.1: Harun Farocki, Auge/Maschine, 2001, 2-Kanal Videoinstallation, Screenshot. Copyright: Harun Farocki GbR

Farocki schaut hier jedoch einem zum damaligen Zeitpunkt noch recht unbekannten Bildtypus bei der Arbeit zu: operativen Bildern. Bildern also, die als algorithmische Operationen in einen Prozess eingebettet sind. Diesen Bildern kommt eine neue Funktion zu. Anders als Gemälde in einem Museum, anders als Fotografien auf der Wohnzimmeranrichte oder auf dem Smartphone heute, sind sie nicht für menschliche Augen bestimmt, sondern werden in erster Linie hergestellt, um von Maschinenaugen gelesen zu werden. Die von Farocki beschriebenen Bilder haben weder ästhetische noch didaktische Funktion, sondern sind Bestandteil eines Apparates, der Leben lenkt, kontrolliert oder zerstört, sich selbst aber der unmittelbaren Sichtbarkeit entzieht. Bereits im Titel weisen Farockis Arbeiten auf den Bildtypus der operativen Bilder hin, der in verschiedenen militärischen, zivilen und kommerziellen Bereichen bis hin zum Einschliessungssystem der Moderne schlechthin, dem Gefängnis, Anwendung findet. Mittels operativer Bilder werden smart bombs, Raketensprengköpfe, zum Ziel geleitet (Erkennen und Verfolgen, 2003), Routen von Konsument*innen in Einkaufszentren erkannt und optimiert (Schöpfer der Einkaufswelten, 2001) und Gefängnisinsass*innen mit einer digitalen Fessel am Knöchel in Echtzeit überwacht (Gefängnisbilder, 2000). Farockis präzise Beobachtungen in den zwischen 2000 und 2003 entstandenen Videoessays Auge/Maschine I-III zerren diese Bilder aus ihrem technisch-mythologischen Apparatzusammenhang heraus und machen die sozialen Verhältnisse sichtbar, die ihre Existenz überhaupt erst möglich machen.

Die farbigen Hilfslinien, welche die operativen Bilder durchziehen, rechteckig oder rund und manchmal wie eine Kinderkritzelei anmutend, sollen „die Arbeit des Erkennens zur Darstellung bringen. Die Linien teilen nachdrücklich mit, worauf es in den Bildern ankommt und ebenso nachdrücklich, worauf es auf keinen Fall ankommen soll. Das überschüssige Reale wird verleugnet – eine stetige Verleugnung mit Gegenwirkung“, wie Farocki schreibt (Farocki 2003).

Die Arbeit des Erkennens zu porträtieren bedeutet gegenwärtig, die Frage nach Sichtbarkeit und Unsichtbarkeit auf die Verhältnisse des 21. Jahrhunderts hin zu aktualisieren, gerade weil sich das Herauszerren und Sichtbarmachen dieser Bilder heute, knapp zwei Jahrzehnte später, noch viel schwieriger gestaltet. Farockis operativer Bildkatalog verweist paradigmatisch auf die Evolution dieser Bildform. Während Bildprogramme Anfang der 2000er Jahre noch durch farbige Linien die Arbeit des Algorithmus zumindest teilweise sicht- und somit nachvollziehbar für menschliche Augen machen, findet dieser Prozess mittlerweile automatisiert und damit im Unsichtbaren statt. Heutige sehende Maschinen benötigen keine Hilfe mehr, Überwachungsbilder werden automatisch gelesen, erkannt und geben anschliessend entsprechende Handlungsoptionen aus.

Die Automatisierung menschlichen Sehens ist mittlerweile allgegenwärtig und machine vision eine wichtige Protogeschichte der Entwicklung maschinellen Lernens beziehungsweise sogenannter Künstlicher Intelligenz (KI). Halten wir zunächst fest: Es ist aufgrund der zunehmenden Abstraktion und Komplexität der technischen Form dieser Bilder schwieriger geworden, sich ihnen mit Farockis Methode der Bildanalyse zu nähern. So ist es beispielsweise nicht möglich, neuronalen Netzen direkt bei ihrer Arbeit der Gesichtserkennung zuzusehen. Firmengeheimnisse und militärische Abschirmdienste tun ihr Übriges. Was ist heute also noch sichtbar, was wäre heute noch filmbar? In diesem Beitrag versuche ich, der beschriebenen Schwierigkeiten zum Trotz, genau hinzuschauen, wo und von wem operative Bilder heute, im Zeitalter von KI, produziert werden. So werden die Produktionsverhältnisse sichtbar, um gegen ein oberflächliches Verständnis immateriellen information flows zu argumentieren, gegen Automatisierung als die schlichte Ersetzung menschlicher Arbeitskraft durch maschinelle.

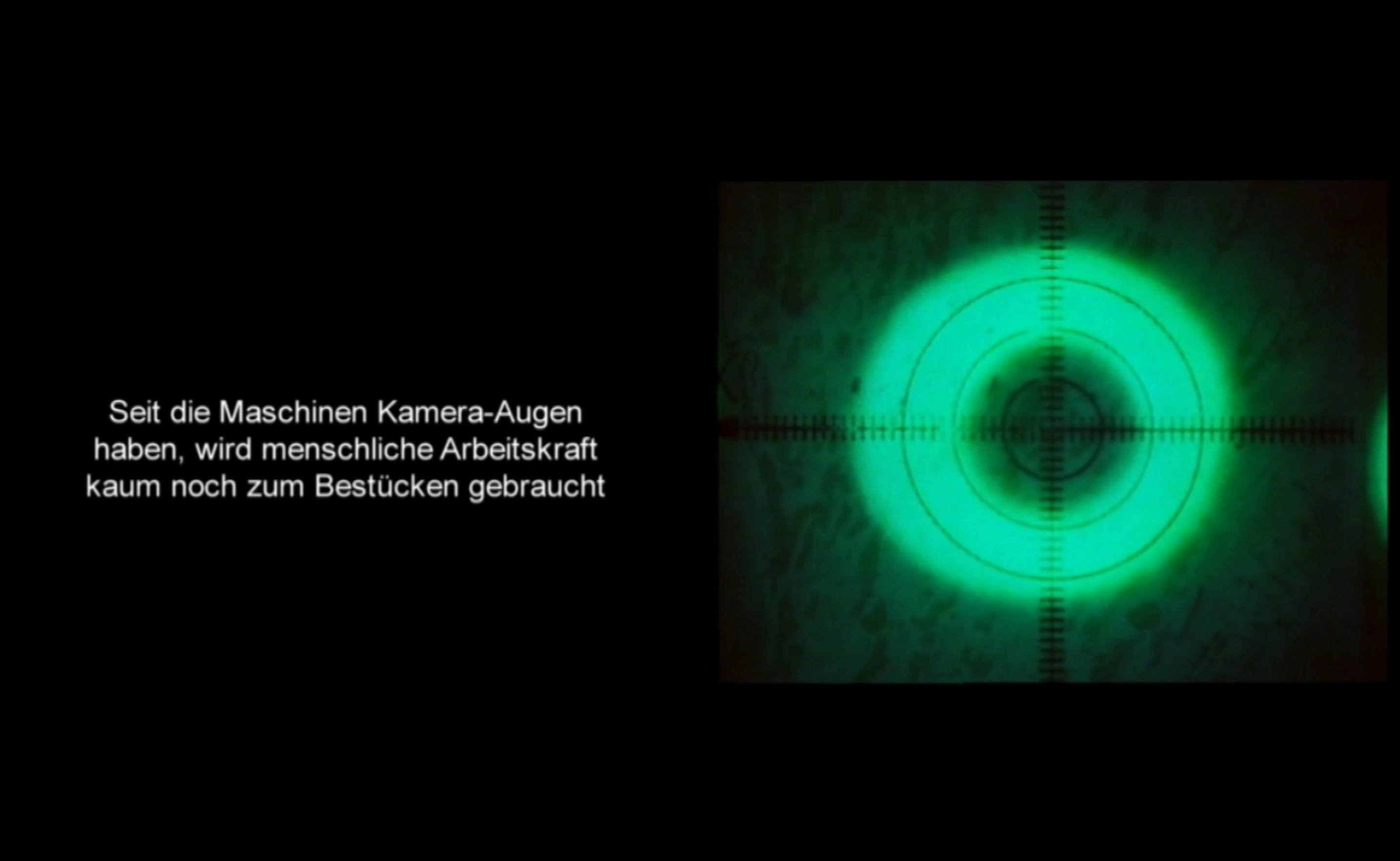

Abb. 2: Harun Farocki, Auge/Maschine II, 2002, 2-Kanal Videoinstallation, Screenshot. Copyright: Harun Farocki GbR

Farockis Portraits der Arbeit des Erkennens erzählen uns von der Evolution eines neuen visuellen Regimes: Die Industrialisierung des Sehens entwickelte sich an den Orten des Militärs, des Gefängnisses, der Fabrik und des Labors. Seine Portraits erinnern uns daran, wie intrinsisch Orte der Zerstörung und der Produktion in unserer Wirtschaftsordnung miteinander verbunden sind. Dabei moduliert die kapitalistische Arbeitsteilung massgeblich die Formen industriellen Sehens. „Seit die Maschinen Augen haben, wird die menschliche Arbeitskraft kaum noch zum Bestücken gebraucht“, liest man in Auge/Maschine II (Farocki 2002). Wie Fabrikroboter zunächst manuelle Arbeiter*innen zum Modell genommen hatten, bis sie diese überflügelten und überholten, haben wenig später schon Sensorautomaten die Arbeit des menschlichen Auges ersetzt. „Die Industrie schafft die Handarbeit ab und ebenso die Augenarbeit“, heisst es in Auge/Maschine II. Und weiter: „Die Maschinen tun die Arbeit jetzt blind“ – eben ohne soziale Absicht, ihre Bilder existieren nicht zur Erbauung, sondern lediglich zur Funktionserfüllung innerhalb der ihnen zugeordneten Operation (Farocki 2002). Maschinen konnten nun sehen, blind zwar, dennoch mit ihren eigenen Augen, als Sehmaschinen (vgl. Virilio 1989). Diese Form der blinden Automatisierung ist längst aus der Fabrik in die Gesellschaft gewandert, beispielsweise in Form von Gesichtserkennungsalgorithmen und predictive policing, die bestehende gesellschaftliche Rassismen und Genderdiskriminierungen automatisiert reproduzieren und so den rückständigen Status der Gegenwart in einer redundanten Schleife konservieren (vgl. Amoore/Raley 2017, Keyes 2019).

In einer weiteren Sequenz in Auge/Maschine nehmen wir die Perspektive eines grünen Kameraauges ein, das unseren Blick lenkt, ein weiteres Portrait der Arbeit des Erkennens zeichnet und, wie Farocki sagt, der menschlichen Augenarbeit ein Ende setzt. Das trifft zwar auf die Fabrik zu und doch geht die Augenarbeit weiter, ja sie ist heute wichtiger denn je. KI ist dringend auf diese Augen angewiesen und Menschen bringen ihr bei, zu sehen. Mehr noch, Automatisierung bedeutet weniger Ersetzung als Verlagerung von Arbeit. So verwenden etwa Hamid Ekbia und Bonnie Nardi den Begriff der Heteromation, um zu zeigen, dass Maschinen nicht autonom arbeiten, sondern beständig auf vielerlei Weise um Hilfe rufen, nach menschlicher Supervision verlangen und menschliche Arbeitskraft benötigen (vgl. Ekbia/Nardi 2017). Es gibt keine Autonomie der Maschinen, sie werden vielmehr durch menschliche Arbeitskraft in Bewegung gebracht und angetrieben.Siehe hierzu Adam Harvey’s und Julian LaPlace’s Projekt https://megapixels.cc, das sowohl die Ursprünge von Datensets zu Gesichtserkennung, die ungefragt aus dem Internet heruntergeladen und verwendet werden, als auch die Datenschutz Implikationen kritisch erforscht.

Die Arbeit findet heute, im kognitiven Kapitalismus, an anderen Orten als der Fabrik des Industriezeitalters statt. Die Sehmaschinen imitierten eine vorher bestehende menschliche Arbeitsteilung, ersetzten die Arbeiter*innen und schufen zugleich neue Arbeitsfelder. Zur neuesten Generation operativer Bilder zählt die maschinelle Intelligenz von KI-Anwendungen. Der Theoretiker Matteo Pasquinelli macht darauf aufmerksam, dass KI Analogien zu Farockis operativem Bildbegriff aufweist und weist auf die „[the] fading distinction between image and logic, representation and inference, in the current technical composition of AI. The statistical models of machine learning are operative representations“ (Pasquinelli/Joler 2020). Die statistischen Modelle maschinellen Lernens können wir als operative Repräsentationen verstehen, epistemische Instrumente, die zwar niemals wirklich die Wirklichkeit wiedergeben, deren Mustererkennung sich aber als äusserst effizient in Bezug zu Farockis überschüssigem Realen erweisen – jene stetige Verleugnung mit Gegenwirkung.

Obwohl es – wie erläutert – nicht möglich ist, neuronale Netze bei ihrer Arbeit der Gesichtserkennung zu portraitieren und heute unmöglich erscheint, einen direkten Zugang zu den Laboren und Firmen zu erhalten, gibt es dennoch eine andere Zugangsweise, die uns mindestens genauso viel, wenn nicht sogar mehr, über die soziale und ökonomische Form verrät, in der die neue Generation operativer Bilder eingebettet ist: Den Menschen bei ihrer kognitiven Arbeit über den Rücken zu schauen.

Das Rückgrat der operativen Bilder

Im Folgenden möchte ich das Augenmerk auf die Herstellung und Produktion legen und weniger auf die Zirkulation bereits fertiger Technologien. Der Begriff Globalisierung hat die Tendenz zur Leere, zur Abstraktion: Denn wo genau findet Globalisierung statt, wo wird sie produziert, wo programmiert, wo materialisiert sie sich (vgl. Aneesh 2006)? Daher sollen in den komplexen planetarischen Infrastrukturen der uns umgebenden technospheres insbesondere die aus westlicher Sicht meist vernachlässigten Gegenden oder als globale Peripherien verstandenen Orte wie Flüchtlingscamps in den Blick genommen werden. Diese im akademischen Diskurs noch zu wenig diskutierte Perspektive, die meines Erachtens jedoch für eine umfassende Kritik wichtig ist, soll in diesem Beitrag anhand der Ökonomie operativer Bilder stark gemacht werden. An diesen Orten wird nichts weniger als die Zukunft des Westens getestet und gesichert: Hier werden biometrische Anwendungen zur Identifikation verbessert und schliesslich normalisiert – ohne Augenscan gibt es mittlerweile keine materielle Hilfe durch die humanitären Institutionen des Westens wie dem UNHCR (Dongus 2019).

Für Vermessungen von Gesicht, Augen und Körper wurden Geflüchtete, Marginalisierte und als abnormal markierte Menschen jahrhundertelang gezwungen, das materielle Substrat zu liefern, um die auf Whiteness hin kalibrierten biometrischen Templates der Moderne zu produzieren, die sie dann in ihren eigenen Gesellschaften erneut ausschliessen und diskriminieren würden.Der Historiker Keith Breckenridge zeigt, dass Südafrika mehr als ein Jahrhundert lang Laboratorium für das Testen biometrischer Anwendung war, welche von dort in andere Länder exportiert wurden und so als Inkubator für „forms of racist government“ diente. Vor allem arme Südafrikaner*innen, Frauen* und Kinder waren der Fehleranfälligkeit des Fingerabdruckverfahrens und teilweise der Willkür während der Registrierung ausgesetzt. Trotz weitverbreitetem Widerstand und Protest der Bevölkerung: Südafrikaner*innen zahlten einen hohen Preis, damit biometrische Systeme in Südafrika und andernorts heute überwiegend effizient und robust funktionieren, so Breckendridge (vgl. Breckenridge 2014: 213). Zum Begriff der white templates siehe Pugliese, Joseph (2010): Biometrics. Bodies, Technologies, Biopolitics. New York, Routledge. Ihre Körper aus den wild zones des globalen Südens waren und sind Lieferant*innen einer fragwürdigen Politik der Sicherheit in Form von automatischer Erkennung, die für die tame zones des globalen Norden spätestens seit 9/11 zum unverzichtbaren Bestandteil angloamerikanischer Überwachungsapparate wurde.Zum Begriff der tame und wild zones siehe Lindskov Jacobsen, Katja (2009): Making design safe for citizens. A hidden history of humanitarian experimentation. In: Citizenship Studies, Vol. 14, No. 1/Februar 2010, S. 89-103.

Die Produktionsprozesse in Informationsgesellschaften sind mittlerweile weltweit vernetzt. Innerhalb dieses neuen Universums ist das Online Outsourcing zentraler Referenzpunkt globalisierter Arbeitsteilungen. Nicht-Regierungsorganisationen und Tech-Unternehmen heuern Geflüchtete in Flüchtlingscamps als Klickarbeiter*innen für die Gig Economy an, damit diese wiederum im Online Outsourcing Markt für jene Unternehmen tätig werden können, wie ich im Folgenden ausführe. Die Geografie neu entstehender Informationsindustrien zeigt sich im rasant steigenden Bedarf exakt annotierter Trainingsdaten, die beispielsweise die Autoindustrie für das autonome Fahren benötigt. Sie erstreckt sich über den gesamten Globus und bleibt asymmetrisch: Millionen Arbeiter*innen erhalten Kleinstbeträge, während die neuen informationellen Infrastrukturen, denen sie zuarbeiten (bspw. neuronale Netze), in den Händen weniger Tech-Oligarch*innen oder Automobilhersteller*innen verbleiben (vgl. Schmidt 2019).

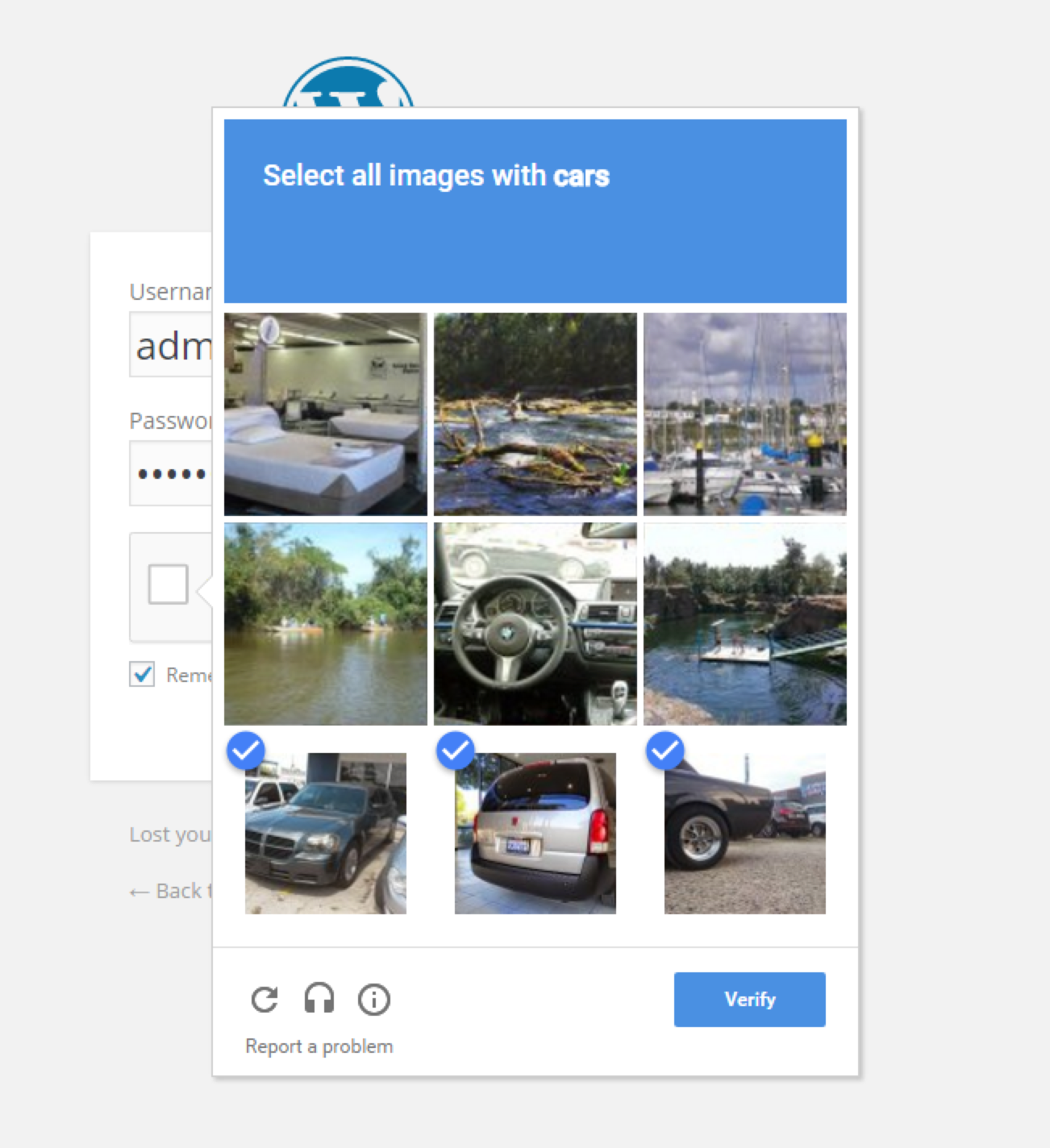

Abb. 3: free labour für ReCAPTCHA trainiert Google’s neuronales Netzwerk, Screenshot [15.07.2019].

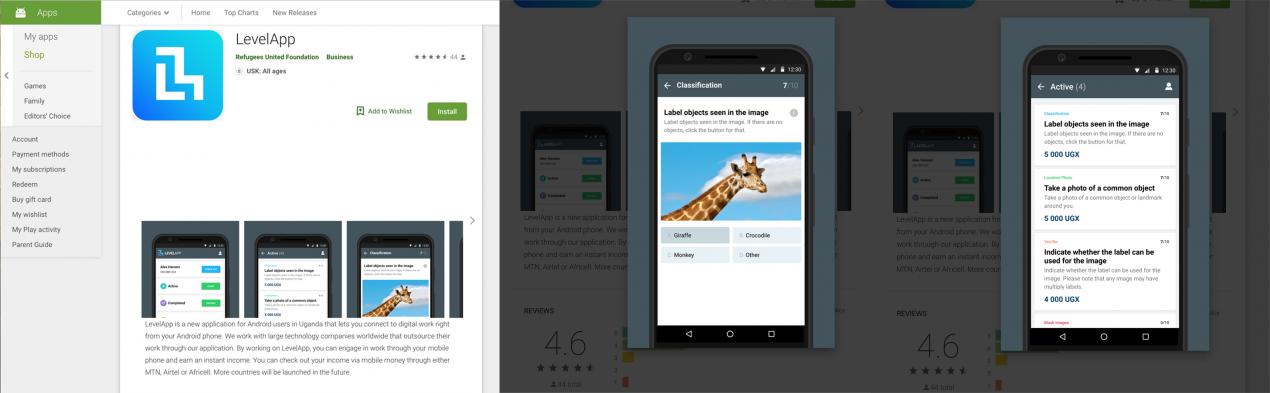

Ob das Testen von biometrischen Anwendungen oder das Labeln von KI-Trainingsdaten: Die Arbeit der Erkennung ist hierbei zentral. Es lässt sich sowohl hier als auch bei der free labour (Terranova 2000: 37), die wir den sozialen Medien oder Google’s reCAPTCHA liefern, sagen: To look is to labour (vgl. Beller 2006, 2018). Dieser Satz stammt von dem Medientheoretiker Jon Beller und beschreibt treffend, was beim Einloggen auf Facebook im globalen Norden, aber vor allem an Orten des globalen Südens wie etwa Camps oder Favelas als prekäre Arbeit verrichtet wird.Zu Favelas als experimentellen Testlaboratorien siehe auch Amar, Paul (2013): Security Archipelago. Human-Security States, Sexuality Politics, and the End of Neoliberalism. Durham, Duke University Press. So verbessert in Uganda die Arbeit von Geflüchteten die maschinelle Intelligenz. Die Nicht-Regierungsorganisation Refunite hat 2018 die Crowdsourcing-Anwendung LevelApp veröffentlicht. Geflüchtete, die in Camps auf Rückkehr in ihre Heimat und eine friedlichere Zukunft hoffen, laden die App wieder und wieder, um als Erste*r die neuesten gigs zu ergattern. Sie sollen Bilder annotieren (label objects seen in image) und Fragen wie Ist dies eine Giraffe? beantworten. Zudem sollen sie selbst Fotos von ihrer Umgebung aufnehmen und in die App einspeisen.

Abb. 4: Android Store bietet die App LevelApp zum Download an, Screenshot [15.07.2019].

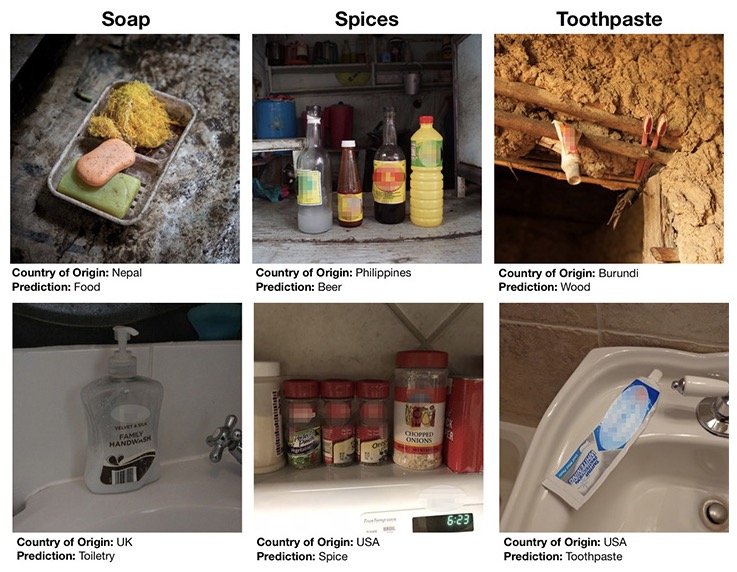

Bildschirmarbeit beschreibt die mechanische Performance der Geflüchteten und vielleicht wäre eine präzisere Beschreibung statt Augenarbeit in diesem Falle perceptional labour, also die Arbeit des Wahrnehmens. Dabei entblösst der nun folgende Blick hinter das Interface und die Aufgabe to take a photo of a common object, ein neues, komplexes Verhältnis zwischen armen und reichen operativen Bildern. In einem aufschlussreichen Forschungsbericht aus Facebook’s KI-Forschung, der davon handelt, bias, also Verzerrungen und Fehler bei ihren object recognition-Algorithmen zu verringern, wird die Limitierung grosser westlicher Datensets wie beispielsweise ImageNet problematisiert (DeVries/Misra/Wang/Van der Maaten 2019).

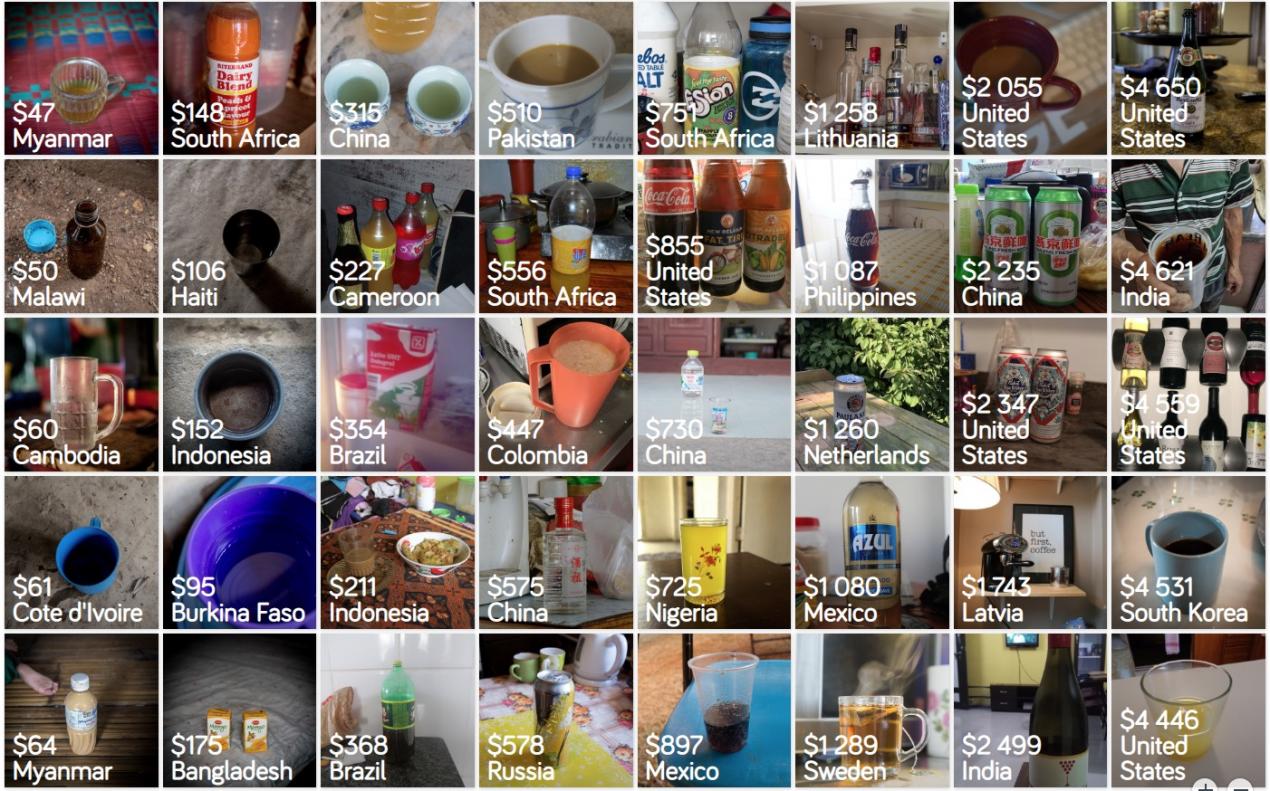

Auf der Grundlage dieser Sets wurden die westlichen Algorithmen trainiert. Deshalb versagt ihre Mustererkennung ausserhalb der begrenzten Enge der westlichen Welt, welche, selbstredend, geografisch in überwältigender Minderheit ist. Bei Facebook versucht man daher die ganze Welt abzubilden, und westliches Material repräsentiert eben nur einen Bruchteil der planetaren Bevölkerung. Die Forscher*innen benutzten die frei verfügbare Datenbank Dollar Set, um die Präzision ihrer object recognition-Algorithmen zu testen. Dollar Set beinhaltet 30.000 Fotos von Haushaltsgegenständen von 264 Familien in 50 Ländern, immer in Bezug zum monatlichen Einkommen gesetzt: Ein Seifenstück ist eben nicht gleich ein Seifenstück und die ökonomische Matrix von social drinks (Getränke etwa, die man mit Familie und Freund*innen zu sich nimmt) unterscheidet sich je nach Einkommen. Dies entspricht einer klassistischen Strukturierung von Bildern. Was hier zählt, ist die ökonomische Herkunft, weniger die Nation. Facebooks algorithmischer Testlauf mit den Dollar Set Daten zeigte, dass ihr Algorithmus eine hohe Fehlerrate ausserhalb der angloamerikanischen Welt aufwies.

Um diese Lücke zu korrigieren, scheint es für high-tech Firmen generell einen grossen Bedarf an nicht-westlichen Datensets zu geben, eine weitere Variante epistemischen Kolonialismus, durch das Training anhand von Bildern von Alltagsgegenständen aus dem globalen Süden eben genau diese Orte zu kapitalisieren.Mehr zum Begriff epistemischer Kolonialismus von KI siehe Pasquinelli, Matteo (2019): „Three Thousand Years of Algorithmic Rituals. The Emergence of AI from the Computation of Space.“ In: Julieta Aranda, Brian Kuan Wood, Anton Vidokle, eds.: e-flux Journal, Nr. 101/Juni 2019. https://www.e-flux.com/journal/101/273221/three-thousand-years-of-algorithmic-rituals-the-emergence-of-ai-from-the-computation-of-space/ [06.07.2020].

Abb. 5: Gapminder/Dollar Street, Datenbank Dollar Set, 264 Familien in 50 Ländern; 30.000 Fotos von Haushaltsgegenständen, um die Diversität zu erhöhen, online unter: https://www.gapminder.org, Screenshot [15.04.2020].

Abb. 6: Die ökonomische Matrix von social drinks. Die Dollarzahl gibt das monatliche Einkommen der befragten Familien an, online unter: https://www.gapminder.org, Screenshot [15.04.2020].

Es drängt sich der Eindruck auf, dass es weniger darum geht, die Welt lesbar zu machen, sondern vielmehr darum, sie ausführbar zu machen, sie in operative Module zu strukturieren. Aus dieser Perspektive muss es das Ziel von high-tech Firmen sein, nicht nur die westliche Welt zu erkennen, sondern den ganzen Planeten. Inklusiv zu sein, bias zu verringern, liegt dann systemisch in ihrem Interesse. Daher müssen die Algorithmen zwangsweise trainiert werden, Fülle, Vielfalt und Diversität zu lesen, insbesondere in den sogenannten Entwicklungsländern, da diese als neue Absatzmärkte entdeckt werden und die Diversität zudem ein wertvoller Lieferant von operativem Bildrohmaterial ist. Es ist nicht unwahrscheinlich, dass die Nachfrage nach diesen Datensets steigen wird und in Uganda die Geflüchteten gerade derlei Bilder annotieren.

Maschinelles Lernen ist also intrinsisch mit der Herstellung von Trainingsdatensets verbunden. Das geht nicht smart und automatisch wie von Zauberhand. Vielmehr sind es die prekarisierten Hände von Arbeiter*innen der Gig Economies. Die Zauberin ist ein Arbeiter*innenkollektiv. Der Mythos entpuppt sich als Arbeitskraft und die maschinelle Smartness als nichts anderes als kollektive menschliche Intelligenz, kondensiert als planetarische Arbeitsteilung. Auch wenn die Arbeit oftmals keine Vorkenntnisse benötigt, somit in der Regel niedrig entlohnt wird, bereitet sie die materielle Basis für das Training von high-tech neuronaler Gesichts- und Objekterkennung vor. Die perceptional labour, Farockis Arbeit des Erkennens, ist von grösserer ökonomischer Wertigkeit, als lediglich die globalen Hinterhöfe der Tech-Firmen zu fegen und ihre Datenvorräte zu organisieren. Diese unsichtbare Arbeit macht auch deutlich, dass die operativen Bilder nur durch die lebendige Arbeit animiert wurden: Sie sind nur deshalb operativ geworden, weil vorher (prekäre) Arbeit in sie investiert wurde. Die Pixel, sie sind lebendig.Zudem wird die Arbeit zugleich im Produkt (privatwirtschaftliche KI-Industrie im globalen Norden) absorbiert, welche dann wiederum eine neue Variation von Heteromation, dem maschinellen Ruf nach menschlicher Arbeit, ermöglicht, indem sie die Automatisierung komplexer Aufgaben wie perceptional labour weiter verbessert: Es mag sicherlich eine Zeit kommen, zu der keine Bildannotierer*innen mehr benötigt werden, sondern KI-Anwendungen eine neue Form der Betreuung von Arbeiter*innen verlangen. Eine weitere Iteration von Arbeitsverlagerung wird begonnen haben.

Die höhere Flexibilisierung der Ströme von digitaler Arbeitskraft, Dienstleistungen und Waren macht aus der Perspektive des Kapitals eine Einhegung dieser Bewegung und Kräfte notwendig. Es drängt sich die Frage auf, ob biometrisches Identitäts-Management eine technische Antwort auf ein sozio-ökonomisch notwendig gewordenes Bedürfnis im kognitiven Kapitalismus ist: Die feingranulierte und individualisierte Vermessung von Produktivität in der sozialen Fabrik der Gesellschaft im 21. Jahrhundert.Einführend zum Begriff der sozialen Fabrik aus der Perspektive der post-operaistischen Tradition siehe auch Mezzadra, Sandro (2013): „Operaism and post-Operaism. Entry for the Encyclopedia of Revolution“, online unter: http://imediata.org/indditec/?p=238 [06.07.2020].

Indigenous Circuits

Die Hierarchie dieser neuen Arbeitswelten spiegelt, wenig überraschend, altbekannte Gender, Race und Class Strukturen älterer Technologien wider.Die Individualisierung von Mikrojobs macht organisierten Protest schwer bis unmöglich, obwohl es mittlerweile einige Initiativen gibt, um die Arbeitgeber*innen zur Verantwortlichkeit zu bewegen. Beispielsweise TurkOpticon, gegründet von Lilly Irani. Dort können Arbeiter*innen schlechte Arbeitsbedingungen veröffentlichen, so dass zukünftige Arbeiter*innen keine Jobs von diesen Unternehmen annehmen: Webseite „Turkopticon“, online unter: https://turkopticon.ucsd.edu/ [06.07.2020]. In Indigenous Circuits: Navajo Women and the Racialization of Early Electronic Manufacture weist die feministische Medientheoretikerin Lisa Nakamura nach, dass Computer-Hardware, insbesondere in den Gründungsjahren des Silicon Valleys, massgeblich von einer Gruppe von Women of Color produziert wurde. Navajo Frauen* bauten in Shiprock, New Mexico auf ihrem Navajo Land in der Fairchild Produktionsstätte Halbleiter zusammen. Ihre Arbeit blieb unsichtbar und die Arbeiterinnen* selbst namenlos. Sie finden im Silicon Valley Kanon keine Erwähnung. Eine Tatsache, die sie mit zahllosen weiteren Arbeiter*innen verbindet, die von der dominanten angloamerikanischen Geschichtsschreibung unerwähnt bleiben. Frauen* produzierten nicht nur Hardware, sie waren zudem während des Zweiten Weltkrieges bis in die Nachkriegsjahrzehnte hinein an vielen Orten auch für die Software zuständig. Geschichte wiederholt sich, denn ursprünglich waren mit dem Begriff computer Frauen* gemeint, bis dann Mitte des 20. Jahrhunderts ihre mentale Rechenarbeit automatisiert wurde. Dieses Schicksal teilen sich Navajo Frauen* und female computers mit unzähligen Assistentinnen* und Laborangestellten* aus den vorangegangenen Jahrhunderten.

Die Historikerin Jennifer Light beschreibt in ihrem Essay When Computers Were Women die essentielle Arbeit von Frauen* für die Entwicklung des ersten elektronischen Computers ENIAC in den USA während des Zweiten Weltkrieges. Sie zitiert den Wissenschaftshistoriker Steven Shapin: „They made the machines work, but they could not make knowledge“. (Light 1999: 474)

Ich würde hier einen Schritt weitergehen und sagen: Sie konnten sehr wohl Wissen machen, denn ihr Wissen brachte die Maschinen schliesslich zum Laufen, jedoch besassen sie dieses Wissen nicht, sondern es gehörte dem Militär bzw. dem Staat, später dann Computer- und Softwarehersteller*innen. Das hat sich bis heute kaum verändert. Zwar sind Arbeitsprozesse im kognitiven Kapitalismus dezentral und flexibilisiert; Arbeitszeit und Produktivität wird in Echtzeit auf Plattformen vermessen und bewertet. Wir erleben eine netzwerkartige Produktion heutiger operativer Rechenmaschinen – jedoch führen die prekären Arbeitsverhältnisse der Klickarbeiter*innen altbekannte Ausbeutungsverhältnisse weiter. Prekarität ausserhalb der Kernorte des globalen Nordens war schon immer globale Norm und die Unsichtbarmachung, Unterschätzung und Ignoranz gegenüber nicht-westlicher Arbeitskraft eine (post-)koloniale Kontinuität. Die asymmetrische Form der Ausbeutung durch Extraktion lebendiger Arbeit ist unverändert und das Vermächtnis der kolonialen Welt kehrt hier als epistemischer Kolonialismus und Extraktivismus zurück (vgl. Pasquinelli/Joler 2020). Die Arbeiter*innen verbessern die Maschinen, erstellen das Futter in Form von Datenbanken, die Millionen Bilder enthalten, um die neuronalen Netzwerke zu trainieren, die uns wiederum automatisch identifizieren. Ihre Arbeit und ihr Wissen, die das Rückgrat der vorgeblich immateriellen cloud-basierten Wirtschaft bilden, im komplexen Informationskapitalismus zur Darstellung zu bringen, ist eine umfassende und wichtige Aufgabe. Die Clouds sind eine behäbige, gigantische Apparatur, deren Gewicht durch die darin enthaltene Arbeit überhaupt erst begriffen werden kann.

Nakamura setzt die Arbeit der Navajo ins Verhältnis zu den integrated circuits der uns prägenden technocultures, im Harawayschen Sinne: Ihre Körper sind Teil digitaler Plattformen, indem sie die menschliche Arbeit zur Verfügung stellen, die benötigt wird, um überhaupt die Infrastruktur aufbauen zu können, die andere dann als Service wahrnehmen können: „Some must labor invisibly for others of us to feel, if not actually be, free and empowered through technology use“.Siehe Nakamura 2014: 919. Weibliche und proletarische Kopfarbeit trägt einen erheblichen Teil dazu bei, dass es Soft- und Hardware gibt – heute wie früher. Um grosse Projekte auf die Beine zu stellen, braucht es eine grosse Arbeiter*innenschaft, eine kollektive Anstrengung. Daher sollte meines Erachtens mehr erforscht werden, welche Rolle unsichtbar und unkenntlich gemachte Wissensschätze, Erfahrungen und spontanes Problemlösen von Frauen* und marginalisierten Personen aus den vergangenen Jahrhunderten spiel(t)en, die all dies mit entwickelten, in Gang brachten und verbesserten.

Die kollektiven sozialen Beziehungen, die unsere heutigen technocultures und Algorithmen neuronaler Netzwerke produzieren, waren immer vorhanden und wurden nicht etwa erst von Maschinen automatisch erschaffen, wie es uns Apologet*innen kommerzieller KI gern weismachen würden. Vielmehr wurde diese Arbeit auf andere Köpfe und Hände übertragen, von den ersten female computers des 19. Jahrhunderts zum Outsourcen von Hardware Produktion zu den Navajo Frauen* im 20. Jahrhundert oder zu den Geflüchteten in den Camps von heute: Hinter dem Mythos intelligenter Maschinen und Künstlicher Intelligenz steckt menschliche kollektive Intelligenz.Zum Begriff der kollektiven Intelligenz siehe auch Pasquinelli, Matteo (2019): „On the Origins of Marx’s General Intellect.“ In: Radical Philosophy, 2.06/Winter 2019. https://www.radicalphilosophy.com/article/on-the-origins-of-marxs-general-intellect [13.07.2020]. Es war und ist weiterhin die kollektive Intelligenz vieler Frauen* (und Männer), die, unsichtbar gemacht von einer eurozentrischen, weissen, männlichen Geschichtsschreibung, unsere heutige von Algorithmen, KI‘s und Interfaces triefende Welt miterbaut haben. Diese Arbeit, die das Rückgrat der angeblich immateriellen cloud-basierten Digitalwirtschaft bildet, sichtbar zu machen, ist eine Aufgabe für uns, die wir forschen. Die Autorin möchte Matteo Pasquinelli, Freia Kuper und Max Grünberg für ihre Kritik, Feedback und Anmerkungen danken.

Literatur und Linkliste:

Amoore, Louise/Raley, Rita (2016): Securing with algorithms. Knowledge, decision, sovereignty. In: Security Dialogue, Vol. 48, No. 1/2017, S. 3-10.

Aneesh, Anesse (2006): Virtual Migration. The Programming of Globalization. Durham, Duke University Press.

Beller, Jonathan (2018): The Message Is Murder. Substrates of Computational Capital. London, Pluto Press.

Beller, Jonathan (2006): The Cinematic Mode of Production. Attention Economy and the Society of the Spectacle. Hanover/London, UP New England.

Breckenridge, Keith (2014): The Biometric State. The Global Politics of Identification and Surveillance in South Africa, 1850 to the Present. Cambridge, Cambridge University Press.

DeVries, Terrance/Misra, Ishan/Wang, Changhan/Van der Maaten, Laurens(2019): „A new way to assess AI bias in object-recognition systems.“In: Facebook Research, Artificial Intelligence and Computer Vision. https://ai.facebook.com/blog/new-way-to-assess-ai-bias-in-object-recognition-systems/ [10.02.2020].

Dongus, Ariana (2019): Galton’s Utopia. Data Accumulation in Biometric Capitalism. In: spheres. Journal for Digital Cultures, Nr. 5/2019.

Ekbia, Hamid/Nardi, Bonnie (2017): Heteromation, and Other Stories of Computing and Capitalism. Cambridge, Massachusetts, The MIT Press.

Farocki, Harun (2000): „Gefängnisbilder“, online unter: https://www.harunfarocki.de/de/filme/2000er/2000/gefaengnisbilder.html [10.05.2020].

Farocki, Harun (2001): „Auge/Maschine“, online unter: https://www.harunfarocki.de/de/installationen/2000er/2000/auge-maschine.html [10.05.2020].

Farocki, Harun (2002): „Auge/Maschine II“, online unter: https://www.harunfarocki.de/de/installationen/2000er/2001/auge-maschine-ii.html [10.05.2020].

Farocki, Harun (2003): Phantom Images. Text based on a talk delivered at ZKM, Karlsruhe, Translation by Brian Pole.

Farocki, Harun (2003): „Auge/Maschine III“, online unter: https://www.harunfarocki.de/de/installationen/2000er/2003/auge-maschine-iii.html [10.05.2020].

Gapminder: „Dollar Street, Data set“, online unter: https://www.gapminder.org/dollar-street/matrix [10.02.2020].

Gray, Mary L./Suri, Siddhartha (2019): Ghost Work. How to Stop Silicon Valley from Building a New Global Underclass. Massachusetts, Houghton Mifflin Harcourt.

Keyes, Os (2018): The Misgendering Machines. Trans/HCI Implications of Automatic Gender Recognition. In: Proceedings of the ACM on Human-Computer Interaction, Vol. 2, No. CSCW, Article 88/November 2018.

Light, Jennifer S. (1999): When Computers Were Women. In: Technology & Culture, Vol. 40, No. 3/Juli 1999, S. 455-483.

Nakamura, Lisa (2014): Indigenous Circuits. Navajo Women and the Racialization of Early Electronic Manufacture. In: American Quarterly, Vol. 66, No. 4/Dezember 2014, S. 919-941.

Pasquinelli, Matteo/Joler, Vladan (2020): „The Nooscope Manifested. Illuminating Artificial Intelligence as Instrument of Knowledge Extractivism“, online unter: https://nooscope.ai/ [19.05.2020].

Schmidt, Florian A. (2019): Crowdsourced Production of AI Training Data. How Human Workers Teach Self-Driving Cars to See. In: Working Paper Forschungsförderung, Hans-Böckler-Stiftung.

Terranova, Tiziana (2000): Free Labor. Producing Culture for the Digital Economy. In: Social Text, 63, Vol. 18, No. 2/Summer 2000, S. 33-58.

Virilio, Paul (1989): Sehmaschine. Berlin, Merve Verlag.