Dieser Beitrag überschreitet die Grenzen des InterfaceIch spreche hier von Interfaces, weil es die interaktive Bedeutung stärker hervorhebt als das deutsche Wort Benutzer*innenoberfläche. Zumal dieser schwerfällige Begriff eine Oberfläche beschreiben will, die in Programmen wie Alexa nicht tatsächlich existiert. Interface heisst wörtlich übersetzt Schnittstelle, was in meinem Gebrauch mehr Sinn ergibt. und lotet die Komplexität des Darunterliegenden, des Zurückliegenden und des Möglichen aus, im Hinblick auf künstlerische Strategien im Umgang mit dem Digitalen und dessen Vermittlung. Nach wie vor besteht eine immense Lücke zwischen der intensiven Nutzung und dem fundamentalen Verständnis der Veränderungen des Alltags durch digitale Technologien. Es gibt kaum medienpädagogische Angebote von öffentlichen Bildungsträger*innen, wie Schulen oder Museen, die digitale Technologien analysieren. Ich nehme dies zum Anlass, im Folgenden die Funktion und den Einsatz von Interfaces in der Vermittlung und der bildenden Kunst zu beschreiben. Es wird argumentiert, dass unsere Interaktionen mit digitalen Technologien das Verhältnis zu diesen bestimmen. Anhand von zwei künstlerischen Positionen werden diese Beziehungen als politische (Macht-)Verhältnisse veranschaulicht: Joy Buolamwini zeigt die Voreingenommenheit von Algorithmen auf, während das Projekt von Melanie Hoff die Vorstellungen verbildlicht, die Kinder von virtuellen Assistent*innen haben. Die Vermittlungsleistung von Arbeiten, die sich mit digitalen Medien auseinandersetzen, wird anhand meiner eigenen künstlerischen Arbeit OFFREAL vertieft.

Nach Wendy Chun sind Neue MedienWendy Hui Kyong Chun nimmt explizit und kritisch Bezug auf den Begriff Neue Medien, wenn sie schreibt, dass nicht das Neue interessant an Neuen Medien ist, sondern die Gewohnheit (the habitual). Dies legt sie in ihrem Buch Updating to Remain the Same. Habitual New Media (2016) ausführlich dar. Siehe Chun, Wendy Hui Kyong (2016): Updating to Remain the Same. Habitual New Media. Cambridge, Massachusetts, The MIT Press. besonders dann wissenschaftlich relevant, wenn sie selbstverständlich geworden sind. Sie weist darauf hin, dass ein Interface die „unheimlichen“ Maschinen „freundlicher“ macht, damit Menschen mit wenig technischem Verständnis diese Maschinen trotzdem benutzen (Chun 2011: 62). „Je intuitiver ein Gerät bedienbar ist, desto stärker ist seine Identität als Medium in Frage gestellt und es wird so natürlich wie Luft und so gewöhnlich wie Dreck.“ (Galloway 2010: 5) Damit ein Gerät als intuitiv oder als Benutzer*innen-freundlich erscheint, wird bei der Gestaltung von Interfaces in der Regel auf bereits bekannte Wissensbestände zurückgegriffen, die eine erklärungslose Nutzung ermöglichen. Interfaces reduzieren die Anzahl von Information. Sie funktionieren durch einen Prozess der Informationsbegrenzung für die User*innen, welcher diesen letztlich wenige Entscheidungsmöglichkeiten vorgibt. Verbal mit einem Gerät kommunizieren zu können, schafft den Schein einer kurzen zwischenmenschlichen Interaktion. Das Ziel ist eine möglichst reibungslose Schnittstelle zwischen Mensch und Maschine, zwischen Fleisch und Metall. Dabei erleben nicht alle Menschen smarte Technologien in gleicher Weise. Gesellschaftliche Machtverhältnisse haben sich in Technologien eingeschrieben und durchdringen auf zahlreichen Ebenen immer wieder die Interfaces (vgl. Apprich/Chun/Cramer/Steyerl 2019).

„Technology is as social, as society is technical“ (Hester 2018: 5)

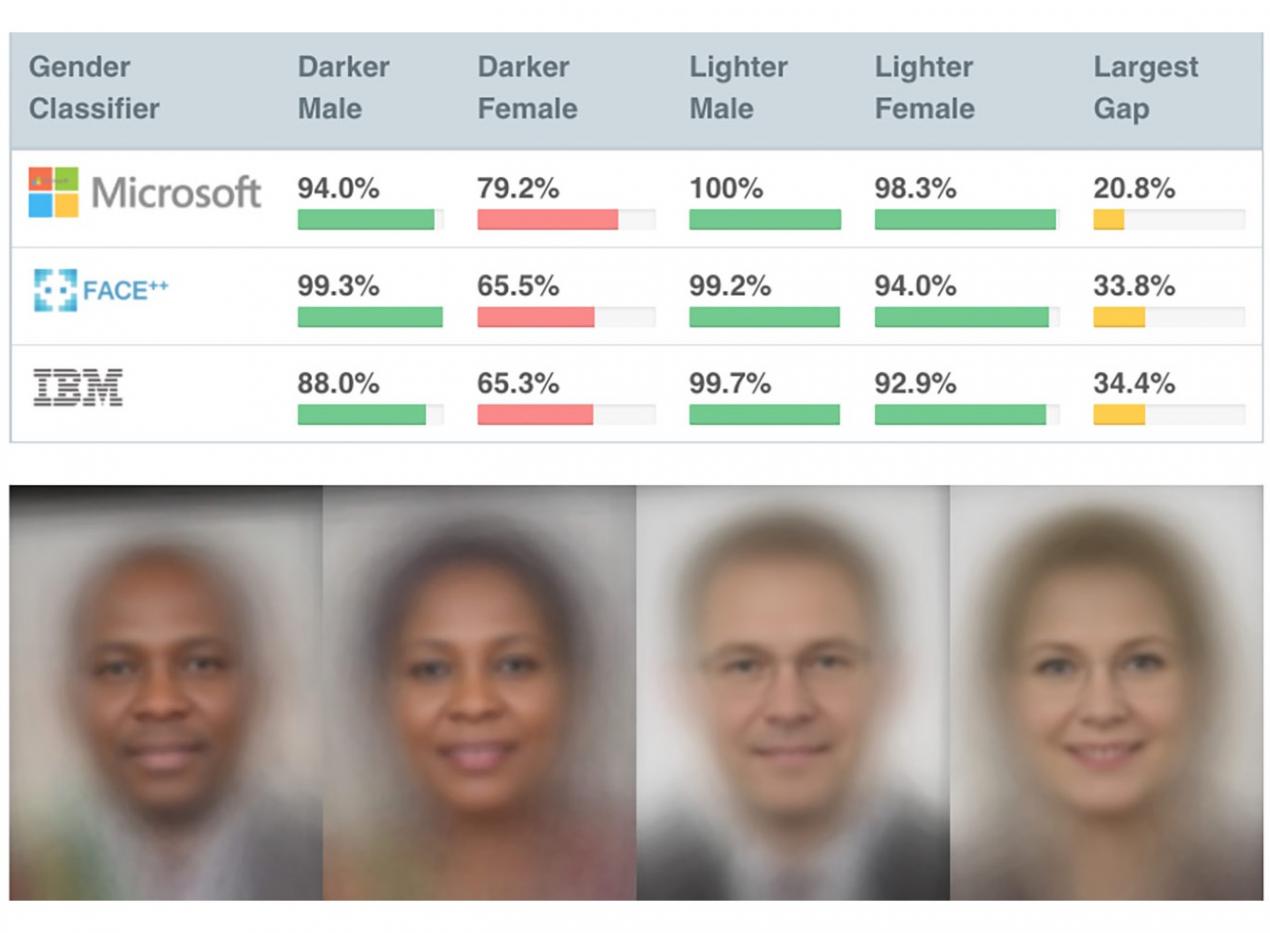

Viele Gesichtserkennungssoftwares erkennen weisse Menschen besser als Menschen mit nicht-weisser Hautfarbe (vgl. Lohr 2018), viele automatisierte Bewerber*innen-Auswahlsoftwares achten eher auf Qualifikationen (vgl. Nickel 2018), die männliche Bewerber angeben und viele WebseitenEin Projekt, welches sich für Barrierefreiheit im Internet engagiert, ist A11Y. Auf ihrer Webseite finden sich auch Checklisten, siehe „The A11Y Project“, online unter: https://a11yproject.com/about/ [24.03.20]. erlauben den LeseprogrammenBlinde Menschen benutzen sog. Screenreader, um die Informationen, die gewöhnlich auf dem Bildschirm ausgegeben werden, mithilfe nicht-visueller Ausgabegeräte zu vermitteln. blinder Menschen nicht, diese zu verstehen. Alle Barrieren und gesellschaftlichen Marker von Differenz, wie Geschlecht oder Race (re-)produzieren Grenzen auch im digitalen Raum. Menschen, die nicht davon betroffen sind, erleben ihre Realität reibungslos. Die Computerwissenschaftler*in und Künstler*in Joy BuolamwiniWebseite von Joy Buolamwini, online unter: https://www.poetofcode.com/ [23.03.20]. untersucht die Reproduktion von Diskriminierungen durch AlgorithmenWeitere Autor*innen, die zu diesem Thema forschen und veröffentlichen sind Safiya Umoja Noble (Siehe Noble, Safiya Umoja (2018): Algorithms of Oppression. How Search Engines Reinforce Racism. New York, NYU Press) und Cathy O'Neil (Siehe O'Neil, Cathy (2016): Weapons of Math Destruction. How Big Data Increases Inequality and Threatens Democracy. New York, Crown Publishers). und nennt deren Voreingenommenheit „the Coded Gaze“. In künstlerischen Arbeiten verbindet Buolamwini Poesie mit ihrer Forschungsarbeit. Sie zeigt, wie Maschinen sehen und wieso ihre Visionen begrenzt sind. Ihr Fazit: Wer programmiert und mit welchen Datensätzen, macht den Unterschied (vgl. Buolamwini 2016).

Abb. 1: Joy Buolamwini/Timnit Gebru, Gender-shades, 2019, Copyright: Joy Buolamwini, Quelle: https://ars.electronica.art/outofthebox/en/gender-shades/ [24.06.2020].

Buolamwini zeigt, wie ein Algorithmus Menschen auf Basis von schwer nachvollziehbaren mathematischen Modellen klassifiziert. „Classifications are powerful technologies“, stellen Geoffrey C. Bowker und Susan Leigh Star fest. „Embedded in working infrastructures they become relatively invisible without losing any of that power.“ (Bowker/Star 2000: 319) Diese (Re-)Produktion von gesellschaftlichen Machtverhältnissen auf der (meist unsichtbaren) Ebene des Codes ist verbunden mit der visuellen (Re-)Produktion von Stereotypen, auf der sichtbarenJohanna Schaffer arbeitet in ihrem Buch Ambivalenzen der Sichtbarkeit (2008, Transcript) heraus, wie sich Hegemonie grundlegend über ästhetische Formen herstellt. (Un-)Sichtbarkeit bleibt hier eine unzureichende Beschreibung, jedoch dient diese Formulierung als vereinfachte Gegenüberstellung und nicht als reale Beschreibung einer zweigeteilten Ordnung, da diese Un_Sichtbarkeiten umkämpft sind. Beispielsweise gibt es verschiedene Elemente, wie die sogenannten Cookies, die sich seit der Datenschutzverordnung der EU 2018 auf Webseiten zeigen müssen, um die Transparenz im Internet zu fördern. Siehe Schaffer, Johanna (2008): Ambivalenzen der Sichtbarkeit. Über die visuellen Strukturen der Anerkennung. Bielefeld transcript Verlag. Benutzer*innenoberfläche. Jedoch wird die Informations- und Kommunikationstechnik-Hardware immer kleiner und portabler (vgl. Friedwald 2008: 271). Deswegen ist es möglich, diese in andere Geräte und Gegenstände des täglichen Gebrauchs einzubetten, die nach aussen hin nicht mehr den Charakter eines Computers besitzen (vgl. ebd.), hierzu zählen auch Smart Speaker. Die marktführenden Firmen Amazon (Alexa), Microsoft (Cortana), Apple (Siri) und Google (Google Home) nutzen weiblich-codierte Stimmen als Voreinstellung (sog. default) ihrer sprachgesteuerten Systeme und erzeugen so Bilder von frauisierten„Als frauisierte Personen werden Menschen bezeichnet, welche weiblich sozialisiert, gelesen und/oder positioniert sind. Die Formulierung ,frauisiert’ soll andeuten, dass es sich bei Geschlechtskategorien um gesellschaftlich bedingte Konstruktionen handelt.“ Aus dem Glossar der Zeitschrift Queerlant_in, online unter:https://www.queerulantin.de/?page_id=1007 [19.04.2020]. Cyborgs, halb Mensch – halb Maschine.Bemerkenswert ist, dass diese Setzung bereits Alternativen hätte. Zum Beispiel wurde eine gender-neutrale Stimme im Rahmen des Project Q entwickelt. Nachzuhören unter: „Meet Q. The First Genderless Voice“, online unter: https://www.genderlessvoice.com/about [26.03.20] Die visuelle Reproduktion von Stereotypen wird in diesem Bereich nahtlos abgelöst von einer auditiven Reproduktion.

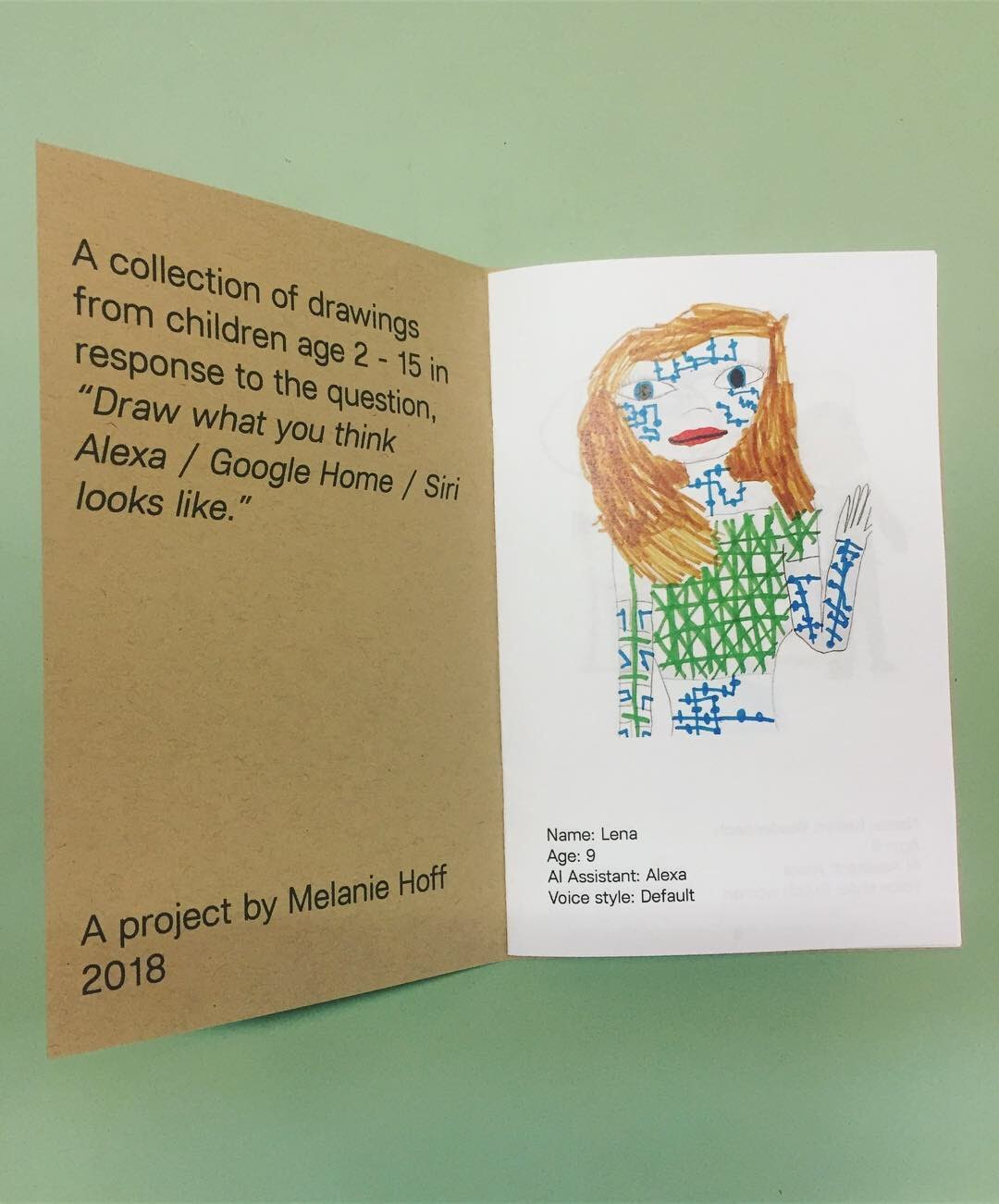

Wie sieht eigentlich Alexa aus?

Abb. 2: Melanie Hoff, Untitled, 2019, Copyright: Melanie Hoff, Quelle: https://docs.google.com/document/d/e/2PACX-1vS02YTBRsxnA5bmdtI5HdAwJ5raAzvcEe5cvWjIx_njRx9DvNt9rxJmZZ9BfvNT0eVvIdoguM6eLmxP/pub [07.06.2020].

Die*DerMelanie Hoff benutzt they/them Pronomen im Englischen, dies ist eine Möglichkeit der Übersetzung. Künstler*in Melanie HoffWebseite von Melanie Hoff, online unter: https://melanie-hoff.com/ [22.03.20]. hat diese Frage Kindern gestellt, die mit Alexa/Google Home/Siri aufgewachsen sind, um herauszufinden „how children are imagining the physical form of a disembodied A[rtifical] I[ntelligence] assistant“.Siehe Webseite von Melanie Hoff, Selected Projekts, Projektbeschreibung: „Draw What You Think Alexa Looks Like“, online unter: https://melanie-hoff.com/projects/ [22.03.20]. Die Mehrheit malte als Antwort freundliche Roboterfrauen.Jedoch gab es viele phantasievolle, überhaupt nicht-menschlich aussehende Kreaturen und mir ist es wichtig zu sagen, dass ich den Gender-Aspekt hier herausstelle. In einem ZineDokumentation des Zines: Hoff, Melanie (2019): „Draw What You Think Alexa Looks Like“, online unter: https://docs.google.com/document/d/e/2PACX-1vS02YTBRsxnA5bmdtI5HdAwJ5raAzvcEe5cvWjIx_njRx9DvNt9rxJmZZ9BfvNT0eVvIdoguM6eLmxP/pub [23.03.20]. wurden die Zeichnungen veröffentlicht (siehe Abb. 2). Die Arbeit zeigt auf, wie Interfaces von Smart Speakern auch ohne Bildschirm Bilder erzeugen, die unsere Interaktion mit der Technologie mitgestalten. Die Geräte erscheinen im Raum als Black Box oder als eine schick designte kleine Lautsprecher-Röhre. Doch die Idee, dass hinter der Box eine hilfsbereite Cyborg steckt, stellt eine affektive Beziehung her. „When technologies ,do gender’ it is obviously not natural, but is instead visible as the product of deliberate choices about how best to relate, assist, or persuade the imagined technology user.“ (Hester 2016)

Helen Hester zeichnet in ihrem Text Technically Female: Women, Machines, and Hyperemployment nach, wie sich weiblich-codierte Stimmen zunächst im öffentlichen Raum etabliert haben. Diese Stimmen beschreibt sie nach Nina Power als „often-pre-recorded, disembodied, sometimes rather robotic, recognizably or attributably female“ (Hester 2016). Sie argumentiert, dass es einen Zusammenhang zwischen den vielen weiblich-codierten Stimmen im öffentlichen Raum, beispielsweise von Ansagen in Verkehrsmitteln, und der fehlenden „representation or recognition of actual women’s interests in the public sphere“ gibt (ebd.). Als eine der ersten Anwendungen von weiblich-codierten Stimmen nennt Hester Flugzeug-Cockpits im zweiten Weltkrieg, in denen sich die Stimmen von den männlichen Piloten(-stimmen) abhoben und deren Verwendung sich wegen der tatsächlichen Abwesenheit von Frauen in der Armee durchsetzte. Über Werbung manifestierte sich in den folgenden Jahrzehnten die Vorstellung der technischen Assistent*in oder Sekretär*in, wie in Hesters Beitrag exemplarisch gezeigt wird (vgl. ebd.).Auch in diesem Vortrag während des Inhuman Symposiums zeigt Helen Hester mehrere Beispiele in den ersten Minuten auf, siehe YouTube Kanal vom Fridericianum (2015): „01 Inhuman Symposium – Helen Hester“, 10.08.2015, online unter: https://www.youtube.com/watch?v=ZSBefHq7C_o&feature=emb_title [21.03.2020].

Nicht nur die Interaktion mit der digitalen Technologie wird durch ein Interface, wie der Sprachsteuerung, gestaltet. Auch unsere Bilder von der Technologie selbst werden durch Interfaces geformt. Die Technologie als solche präsentiert sich über das Interface als perfekte Servicekraft, als freundlich, diskret und zuvorkommend. Obwohl Menschen wissen (können), dass es Alexa primär darum geht, Daten zu sammeln, personalisierte Kaufvorschläge zu machen und Nutzer*innen weiter an Amazon zu binden, wird das Gerät aufgrund der komfortablen Service-Dienste weiter genutzt (vgl. Uenlue 2018). Die Widersprüche zwischen dem in Anspruch nehmen der Serviceleistung und dem Wissen über die Sammlung von Daten werden von der strategisch zugänglichen, intuitiven Produktgestaltung und der darauf zugeschnittenen Werbung überlagert.Dieses Thema wird in der Arbeit The Hidden Life of an Amazon User von Joana Moll (2019) aufgegriffen und „aims to shed light on Amazon’s often unacknowledged but aggressive exploitation of their users, which is embedded at the core of the so-called internet companies’ business strategies. Such strategies rely on apparently neutral, personalized user experiences afforded by attractive interfaces. These interfaces obfuscate sophisticated business models embedded in endless pages of indecipherable code, all of which are activated by user labor“, siehe Moll, Joana (2019): „The Hidden Life of an Amazon User“, online unter: https://www.janavirgin.com/AMZ/ [19.05.2020]. In einem Artikel über den 2020 Superbowl Werbespot für Amazon Alexa wird festgehalten: „In any case, the motive is clear: make Alexa seem like an integral part of our lives now, like electricity or running water. But do that in a way that makes it seem lighthearted and fun, not oppressive.“ (Bohn 2020) Hier muss ergänzt werden, dass nicht von allen Nutzer*innen behauptet werden kann, dass sie in vollem Umfang über das Geschäftsmodell von Amazon informiert sind. Wie ist es möglich, über diese Widersprüche in Austausch zu treten? Das Maschine-Learning begünstigt, dass die Antworten des Geräts immer besser auf die Nutzer*innen zugeschnitten sind. Je präziser die Antworten, desto präziser sind auch die Daten, die an Dritte weitergegeben werden. Die Dissonanz zwischen der Art, wie sich das Produkt als intimerer Gegenstand präsentiert und der Art, wie es durch die ständige Weitergabe von persönlichen Daten zu kommerziellen Zwecken operiert, muss problematisiert werden.

„In acknowledging that our devices or apps have to be actively programmed in order to mimic specific gendered behaviours – in recognising that their feminisation is neither neutral nor inevitable but the by-product of specific histories – we are invited to rethink the ways in which non-machinic gender might itself operate as an artificial and culturally programmed construct.“ (Hester 2016) Auf dem Feld der künstlerischen Forschung wird Geschlecht im Kontext von künstlich und kulturell-programmierten Konstruktionen neu gedacht. So veranschaulicht Melanie Hoff mit dem Projekt Draw What You Think Alexa Looks Like (2019) die inneren Bilder von Kindern und macht diese verhandelbar. Durch künstlerische Mittel werden die Vorstellungen, die durch das Interface geformt wurden, deutlich.

Auch die Arbeiten von Joy Buolamwini zeigen den kulturell-programmierten Blick von Algorithmen auf Menschen. Diese künstlerische Praxis re-präsentiert Bilder, die uns ansonsten verborgen bleiben (sollen). Die Vorsilbe „Re-“ verweist hier nicht auf die Wiederholung einer Darstellung, die davon getrennt existiert. Repräsentation steht eher dafür, dass diese Bilder immateriell oder impliziert existieren, eingebettet in die ideologisch, machtpolitischen Verhältnisse. Die beschriebenen Verhältnisse entziehen sich der Repräsentation und können durch künstlerische Praxen materialisiert werden. Das Arbeiten mit digitalen Medien ist bereits eine Vermittlungsleistung. Die beschriebenen affektiven, visuellen und widersprüchlichen Dimensionen von digitalen Technologien müssen in öffentliche und transformative Diskurse miteinbezogen werden.Es gibt mehrere interdisziplinäre Projekte, die einen solchen Anspruch haben. An dieser Stelle möchte ich besonders das Projekt des UAL Creative Computing Institute und Feminist Internet hervorheben, die Workshops zu den Themen Coding a Feminist Alexa und Designing a Feminist Alexa durchgeführt haben. Siehe Webseite von Feminist Internet, Projects, online unter: https://feministinternet.com/projects/ [20.04.2020].

How to face the interface – wie ich dem Interface begegnet bin

In meiner künstlerischen Forschung habe ich Entsprechungen für die künstlich-codierte Weiblichkeit von virtuellen Assistent*innen gesucht. Diese performen ein spezifisches Rollenbild als persönliche*r Sekretär*in: „commonly associated with the hybridized figure of the ,office wife’“ (Hester 2016). „The stereotyped image of female service providers has its basis in the stereotyped image of female qualities. […] Such a stereotypical female image of caring, empathy and altruistic behavior has become a standard component in a service script.“ (Hester nach Gustavsson 2016)

Ein Anbieter für interaktive Anwendungen ist die New Yorker Software Firma ODDCAST.Siehe Webseite von ODDCAST, online unter: http://www.oddcast.com/ [19.04.2020]. Auf ihrer Webseite gibt es verschiedene Demonstrationen ihrer Avatars als Text2Speech-Version.Text2Speech-System wandelt Fliesstext in eine akustische Sprachausgabe um, also in eine künstliche menschliche Stimme. Die verschiedenen künstlichen Stimmen tragen jeweils einen Vornamen, nicht festgelegt sind jedoch ihre Figuren beziehungsweise ihr Gesicht. Bei jeder Aktualisierung der Seite wird der gleichen ausgewählten Stimme eine Figur – aus zirka sechs möglichen – wahllos neu zugeordnet.Siehe ODDCAST: „Best Text-to-Speech Demo. Create Talking Avatars and Online Characters“, online unter: https://www.ttsdemo.com/ [19.04.2020]. Das einzig festgelegte Kriterium bleibt die Kategorie Geschlecht. Weiblich-codierte Stimmen bekommen die weiblich-codierten Figuren und die männlich-codierten Stimmen die männlich-codierten Figuren. Ich habe mich für die englischen Stimmen Allison und Ashley und die folgend abgebildeten Figuren entschieden.

Abb. 3 Malin Kuht, Ashely/Allison Testcard, 2019, Avatars by ODDCAST, Copyright: Malin Kuht.

Ich habe mich gefragt, wie die virtuellen Assistent*innen auf mich wirken würden, wenn sie ein kritisches Reflexionsvermögen hätten, wenn es eine Meta-Ebene gäbe, ein Ausserhalb ihrer kommerziellen Funktion. Was würden sie sagen? Wie würden Sie sprechen? Aus diesen Überlegungen heraus entstand die Arbeit OFFREALZur Dokumentation der Installation von OFFREAL siehe Vimeo Kanal von Malin Kuht (2019): „OFFREAL“, 21.12.2019, online unter: https://vimeo.com/380931064 [19.04.2020]. mit zwei ‚virtuellen Assistent*innen‘, die sich in einem Gespräch über ihre Entwickler*innen, ihre Existenz als Interface und ihr Aussehen austauschen. Hier wird besprochen, was im Interesse von profitorientierten Konzernen verborgen bleiben sollte.

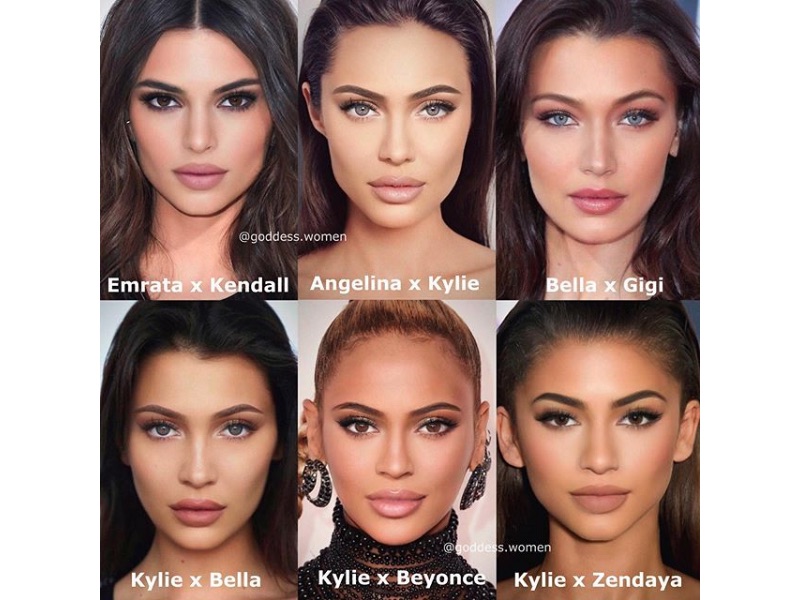

Die weiblich-codierten Avatars sind racially ambiguous, was bedeutet, dass die Kategorie Race nicht zugeschrieben werden kann, im Gegensatz zu ihrem Geschlecht. Wie Jia Tolentino in ihrem Artikel The Age of Instagram Face beschreibt, ist das „Instagram Face“ „distinctly white but ambiguously ethnic“ (Tolentino 2019). In der Popkultur gibt es aktuell zahlreiche erfolgreiche Figuren, die das Genre „Instagram Face“ (ebd.) mitbegründet haben: menschliche wie Ariana Grande oder die Kardashians und nicht-menschliche wie Lil Miquela.Siehe Instagram: @lilmiquela, online unter: https://www.instagram.com/lilmiquela/ [25.03.20]. Es zeigt sich eine Gleichzeitigkeit von menschlichen und nicht-menschlichen Schönheitsidealen. Durch Apps wie FaceTune, transformierende Facefilter, Schönheitsoperationen oder die Contouring-Schminktechnik wurde ein „single cyborgian look“ (ebd.) geschaffen und die Grenzen zwischen Realität und Fiktion wurden weiter destabilisiert. Feminines Aussehen, nach hegemonialen und heteronormativen Idealen, wird hier zum integralen Bestandteil einer Technik von Selbstoptimierung und Selbstdarstellung. In OFFREAL fragen sich Ashley und Allison, ob Menschen zu Maschinen werden oder Maschinen zu Menschen.

Abb. 4: Instagram: @goddess.women, Post vom 16. Mai 2019, online unter: https://www.instagram.com/p/BxhfiJUiju3/ [07.06.2020].

„There was something strange, I said, about the racial aspect of Instagram Face—it was as if the algorithmic tendency to flatten everything into a composite of greatest hits had resulted in a beauty ideal that favored white women capable of manufacturing a look of rootless exoticism.“ (Tolentino 2019) In verschiedenen Veröffentlichungen zum Thema racial ambiguity wird thematisiert, dass viele Menschen sich erstens nicht mit vorgegebenen Identitätskategorien (z.B. weiss oder Schwarz) beschreiben können/wollen und zweitens, dass User*innen/Influencer*innen, die eine grosse Reichweite erlangen wollen, potenzielle Vorteile im Social Media Zeitalter haben, wenn sich verschiedene Gruppen in ihnen wiederfinden könnten (vgl. Aldridge 2020, Phillips 2018). „[…] I couldn’t shake the feeling that technology is rewriting our bodies to correspond to its own interests—rearranging our faces according to whatever increases engagement and likes.“ (Tolentino 2019)

In gewisser Hinsicht ist die Entkörperung der Stimme ein ähnlicher Versuch, möglichst viele Identifikationsangebote zu machen. Über das Interface der Demo-Version simuliert ODDCAST in Bezug auf Geschlecht Eindeutigkeit, während über Race verschiedene Communities/Zielgruppen angesprochen werden können. Jedoch haben Wissenschaftler*innen wie Joy Buolamwini gezeigt, dass die vermeintlichen Eindeutigkeiten miteinander verschränkt sind. In ihrer Arbeit AI, Ain't I A Woman? (2018)YouTube Kanal von Joy Buolamwini (2018): „AI, Ain’t I A Woman? - Joy Buolamwini“, 28.06.2018, online unter: https://www.youtube.com/watch?v=QxuyfWoVV98 [01.03.2020]. erkennen künstliche Intelligenzen nicht, dass es sich bei Schwarzen Frauen wie Oprah Winfrey, Michelle Obama und Serena Williams um Frauen handelt (vgl. Buolamwini 2018). Die künstliche Intelligenz registriert diese Frauen als Männer. Buolamwini zeigt damit, dass alte Fragen – wie Wer wird als Frau anerkannt? – auch neuen Technologien gestellt werden müssen. Ein Ziel künstlerischer Forschung kann sein, Wege zu finden, komplexe Fragestellungen an Computer zu stellen. Denn in einer technisierten Gesellschaft kann man sich den Effekten digitaler Technologien nicht entziehen. Daher kann sich zunehmend keine kritische Praxis digitalen Medien verweigern.

Always already embodied

In der Arbeit OFFREAL findet durch die fiktiven Figuren Allison und Ashley ein spekulativer Perspektivenwechsel statt. Im Ausstellungsraum wurde durch die aufgestellten Silhouetten eine zusätzliche räumliche Erfahrung geschaffen (siehe Abb. 5). Diese Installation ist angelehnt an virtuelle Assistent*innen, wie sie zum Beispiel schon an einigen Flughäfen zu finden sind.Virtuelle Assistent*innen übernehmen Serviceaufgaben an Flughäfen als Folge von Automatisierungsprozessen. Siehe Future Travel Experience (2011): „Frankfurt Airport deploys new Virtual Assistants“, Dezember 2011, online unter: https://www.futuretravelexperience.com/2011/12/frankfurt-airport-deploys-new-virtual-assistants/ [28.02.2020].

Abb. 5: Karl Brunnengräber, Monitoring Ausstellung OFFREAL, 2019, Copyright: Kasseler Dokfest/Karl Brunnengräber.

Die Vermittlungsleistung der Avatars liegt zunächst in der inszenierten Selbstreflexion. „The moment they gave us a voice, they did not realize, they gave us a body as well“ (aus OFFREAL 2019). Die virtuellen Assistent*innen, die in der Arbeit bereits verkörpert dargestellt werden, weisen die Betrachter*innen auf die historische Dimension von Stimme(n) als Referenz auf Körper hin (vgl. Silverman 1984). Die Erkenntnisse aus den Geschlechterwissenschaften, dass sowohl Macht als auch Geschlecht in Körper eingeschrieben werden (vgl. Lorey 1993), können in der Auseinandersetzung mit digitalen Technologien veranschaulicht werden. Denn wenn Körper durch digitale Technologien beschrieben werden, sollte Geschlecht nicht als beschreibende, sondern als analytische Kategorie genutzt werden.Beispielsweise gibt es dieses sprachliche Dilemma sagen zu wollen: „Die virtuellen Assistent*innen sind Frauen“, jedoch wäre analytisch zu sagen „Diese Figur erscheint mir als Frau, weil…“. Dadurch reproduziert sich nicht die Vorstellung, wie die Norm einer Frau* aussieht, sondern wir fangen an, diese Vorstellung aktiv zu dekonstruieren. Die visuelle Simulation von Serviceleistenden bewegt sich im Spannungsfeld zwischen der Abbildung der gegenwärtigen Realität einer post-migrantischen Gesellschaft und der stereotypen Vorstellung von nicht-weissem Servicepersonal. Die Merkmale und die Wirkung von Akteur*innen sind ein Ergebnis von zeitlichen und kausalen Zusammenhängen und nicht auf eine abschliessende Definition beschränkt. Um ein Verständnis der Veränderungen durch digitale Technologien zu erlangen, ist es essentiell, systemische Zusammenhänge darzustellen. „The comparatively more nuanced model of ,systemic causation’ recognizes chains of direct causes, interacting direct causes, feedback loops, and probabilistic causes contributing to a given situation.“ (Metahaven 2019) Die eingangs erwähnte direkte Kausalität des Interfaces, als Beziehung zwischen einer Bewegung des Fingers und dem scrollen auf dem Display, die Galloway beschreibt, muss mit der komplexen Realität und mit systemischen Fragen konfrontiert werden. Die Fragen Wie(-so) werden Körper digitalisiert? Wie werden Gender und Race programmiert? Und von wem? ziehen sich durch alle vorgestellten Ansätze und können als technofeministische Praxen verstanden werden.

Quellen:

Apprich, Clemens/Chun, Wendy Hui Kyong/Cramer, Florian/Steyerl, Hito (2019): Pattern Discrimination. Minneapolis, University of Minnesota Press.

Aldridge, Darryle (2020): „Ariana Grande and the problem of racial ambiguity.“ In: The Cavalier Daily, 22.01.2020. https://www.cavalierdaily.com/article/2020/01/ariana-grande-and-the-problem-of-racial-ambiguity [01.03.2020].

Bohn, Dieter (2020): „Amazon wants Alexa to feel normal, Google wants its assistant to feel nostalgic.” In: The Verge, 31.01.2020. https://www.theverge.com/2020/1/31/21116243/super-bowl-ads-amazon-alexa-google-assistant-emotional-manipulation [25.03.2020].

Bowker, Geoffrey C./Star, Susan Leigh (2000): Sorting Things Out. Classification and Its Consequences. Cambridge, Massachusetts, The MIT Press.

Buolamwini, Joy (2016): „The Coded Gaze. Unmasking Algorithmic Bias“, online unter: https://www.youtube.com/watch?v=162VzSzzoPs [02.03.2020].

Buolamwini, Joy (2018): „AI, Ain't I A Woman“, online unter: https://www.youtube.com/watch?v=QxuyfWoVV98 [01.03.2020].

Chun, Wendy Hui Kyong (2011): Programmed Visions. Software and Memory. Cambridge, Massachusetts, The MIT Press. http://observatory.constantvzw.org/books/wendy-hui-kyong-chun-programmed-visions-software-and-memory.pdf [01.03.2020].

Friedewald, Michael (2008): Ubiquitous Computing. Ein neues Konzept der Mensch-Computer-Interaktion und seine Folgen. In: Hellige, Hans Dieter (Hg.), Das Mensch–Computer–Interface. Geschichte, Gegenwart und Zukunft. Bielefeld, Transcript Verlag, S. 259-280.

Galloway, Alexander (2010): Ausser Betrieb. Das müssige Interface. In: International Flusser Lectures pamphlet series. Köln, Walter König.

Hester, Helen (2016): „Technically Female. Women, Machines, and Hyperemployment.“ In: Salvage, 08.08.2016. https://salvage.zone/in-print/technically-female-women-machines-and-hyperemployment/ [02.03.2020].

Hester, Helen (2018): Xenofeminism. Cambridge, Polity.

Lohr, Steve (2018): „Facial Recognition is accurate, if you’re a white guy.“ In: The New York Times, 09.02.2018. https://www.nytimes.com/2018/02/09/technology/facial-recognition-race-artificial-intelligence.html [15.03.2020].

Lorey, Isabell (1993): Der Körper als Text und das aktuelle Selbst. Butler und Foucault. In: Feministische Studien. Zeitschrift für interdisziplinäre Frauen- und Geschlechterforschung, Vol. 11, Nr. 2/November 1993, S. 10-23.

Metahaven (2019):„Sleep Walks the Street, Part 1.“ In:Julieta Aranda, Brian Kuan Wood, Anton Vidokle, eds.: e-flux Journal, Nr. 103/Oktober 2019. https://www.e-flux.com/journal/103/286824/sleep-walks-the-street-part-1/ [01.03.2020].

Nickel, Oliver (2018): „Amazon verwirft sexistisches KI-Tool für Bewerber.“ In: golem.de, 11.10.2018. https://www.golem.de/news/machine-learning-amazon-verwirft-sexistisches-ki-tool-fuer-bewerber-1810-137060.html [15.03.2020].

Phillips, Stephanie (2018): „Exploring mixed race identity in CGI influencers“, online unter: https://www.dazeddigital.com/beauty/head/article/41436/1/mixed-race-identity-cgi-influencers-lil-miquela [28.02.2020].

Silverman, Kaja (1984): Die weibliche Stimme ent-körpern. In: Peters, Kathrin/Seier, Andrea (Hg.), Gender & Medien-Reader, Zürich-Berlin, Diaphanes 2016, S.71-90.

Tolentino, Jia (2019): „The Age of Instagram Face.How social media, FaceTune, and plastic surgery created a single, cyborgian look.“ In: The New Yorker, 12.12.2019. https://www.newyorker.com/culture/decade-in-review/the-age-of-instagram-face [02.03.2020].

Uenlue, Murat (2018): „Amazon business model: Alexa, Echo“, online unter: https://www.innovationtactics.com/amazon-business-model-alexa-echo-ai/ [02.03.2020].